Sora2掀起技术新浪潮,云知声山海大模型屡获权威认证稳居国产第一梯队

近日,OpenAI推出的Sora2.0以物理真实的视频生成能力与跨模态交互突破引发行业震动,其对多模态信息的深度整合能力,印证了该赛道已成为人工智能技术竞争的核心战场。与此同时,在国内AGI市场,港股AGI第一股云知声(9678.HK)研发山海多模态大模型,并在权威评测中力压国际头部模型,展现出中国多模态技术的硬核实力,为行业发展注入新动能。

权威评测登顶,山海大模型双线突破显实力

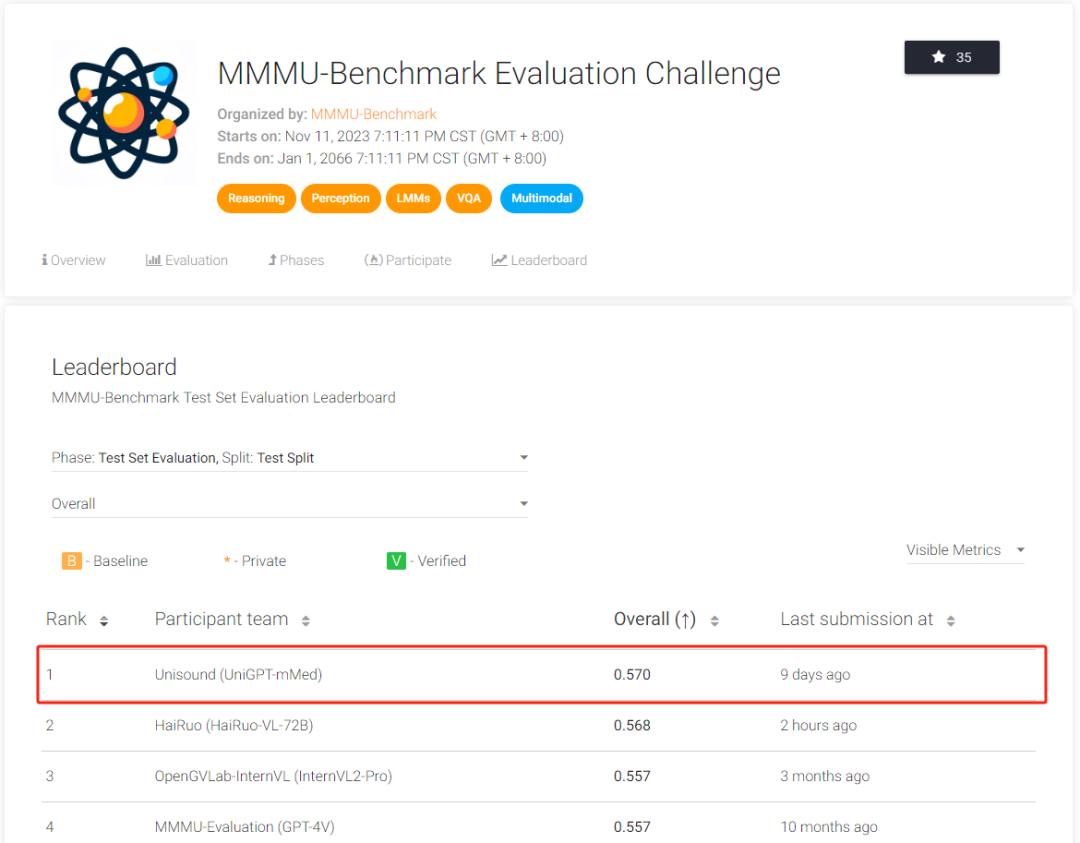

多模态人工智能模型基准评测集MMMU的最新榜单,为行业提供了关键技术参照。作为由IN.AIResearch等机构联合构建的国内权威基准,MMMU聚焦“大学层次多学科问题解决能力”,涵盖艺术与设计、健康与医学、技术与工程等六大领域,包含1.15万个多模态问题,覆盖30个科目、183个子领域,且大量题目需运用傅立叶变换、均衡理论等专业知识完成专家级推理,同时还需应对“多图像格式识别”“文本图像混合输入推理”两大独特挑战,评测难度与专业性均处于行业前列。

正是在这一高标准评测中,云知声山海多模态大模型UniGPT-mMed实现双线突破:不仅以总分57的成绩登顶榜首,彰显一流通用能力;更在健康与医学细分赛道超越GPT-4V,成为该领域首个在MMMU评测中力压国际头部模型的国产大模型。这一成绩的背后,是UniGPT-mMed独特的技术架构支撑——基于云知声山海大模型底座,通过精细化数据处理技术自动识别优质图文数据,结合多模态分析评估图文匹配度,再以思维链、自我反思技术优化场景问答数据集,最终构建起数亿条高质量图文问答数据体系,为精准交互与专业推理奠定基础。

全栈交互能力升级,开启多场景智能新体验

除评测成绩外,山海多模态大模型的实际交互能力更凸显其技术落地潜力。在语音交互层面,该模型实现“实时秒回”,响应速度接近人类对话节奏,用户可随时插话无需等待,同时能通过语音文本、语气、节奏、音调捕捉用户情绪,提供贴合场景的情感反馈,更支持音色自由切换与“一句话声音克隆”,高保真还原用户音色与情感特征;在视觉交互层面,其可通过摄像头精准理解场景、识别物体信息,不仅能完成OCR文字识别,更能结合图文信息生成易懂总结,例如面对投影仪设备时,可同步描述物体特征与包装盒文字核心内容,同时还能根据用户指令快速生成定制化视觉内容,满足创意展示需求。

这种“能听会说、看得见读得懂”的全栈多模态能力,正逐步落地到实际场景中。依托云知大脑(UniBrain)技术中台,山海大模型与多模态感知生成、知识图谱、物联平台等组件深度融合,为智慧医疗、智慧物联、智慧座舱、智慧交通等业务提供支撑——在医疗领域,基于其孵化的医疗大模型已在CCKS2023PromptCBLUE评测中获通用赛道一等奖,MedBench评测中位列全球第一;在智慧生活领域,其解决方案已服务超400家客户,API月调用量峰值突破10亿次,持续推进“U(云知大脑)+X(应用场景)”战略落地。

从Sora2.0的全球竞逐到云知声的本土突破,多模态技术正重构人机交互范式。随着山海大模型持续迭代与政策红利释放,这家AGI先行者有望在智慧生活、医疗健康等领域开辟增量市场,为千行百业的智慧化升级提供核心动能。